静岡大学 学術院情報学領域・情報学部 行動情報学科 教授

ご説明したデータとツールを統合し、ツイート、新聞記事、国会議事録を対象に、投稿テキスト内の含意・矛盾を抽出し、「欺瞞」を検出したあと、「欺瞞」の広がりを予測するため、時系列でリツイート数やリツイートするユーザー群の範囲などをAIで学習、予測します。このユーザー群予測に政治、心理的な個人属性を利用するわけです。そして、伝搬過程を可視化して、傾向をさらに明確化しています。

介入実験では、より受け入れられる投稿を探るために、属性に応じて訂正ツイートの発信をし、その反応を測定、分析していく予定です。

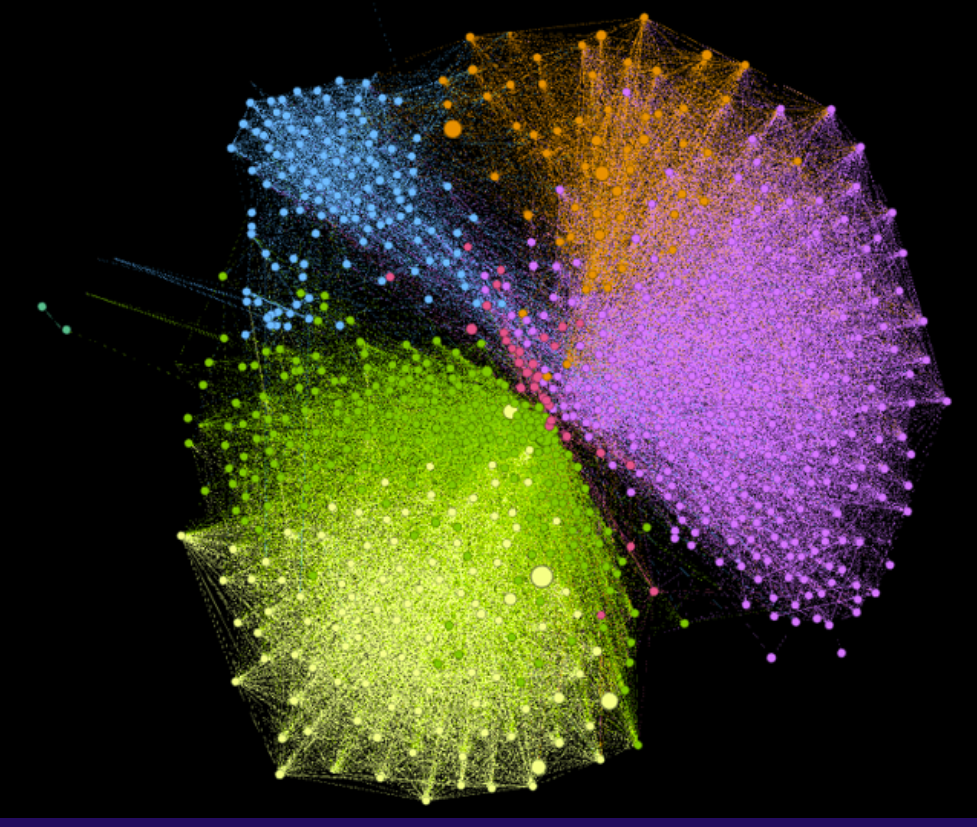

「投稿を可視化したネットワーク図」(読売新聞オンラインより)

「投稿を可視化したネットワーク図」(読売新聞オンラインより)もちろんあります。むしろこの分野は、目まぐるしく日々進化していくので、新たな問題、課題がつきものです。

なかでもこの研究に着手してから、2022年11月にリリースされたChatGPTをはじめとする大規模言語モデルの影響は大きく、さまざまなグループが多額の資金を投じて性能を向上させ、毎日のように新たなモデルが発表されています。私たちも研究成果を確認する際に、毎回ChatGPTなどと性能を比較しなければならなくなりました。

別の主要な問題は、イーロン・マスク氏がツイッターを買収し、Xとしてサービスを開始するに伴い、それまで無料で入手できていた学術利用目的のデータが有料化されたことです。リアルタイムの膨大なデータが入手困難になりました。また、大規模クラウドソーシング調査に応じてくださる方がなかなか増えず、サンプルが不足している状況です。

これに加え、AIの大規模計算処理を高速化するGPU(グラフィックカード)が本研究には必須なのですが、とても高額で予定よりグレードの低いものを購入せざるを得なくなりました。

できる範囲で知恵を絞りつつ、頑張っています。

フェイクニュースや誤情報などの伝播については、現在社会的な問題になっており、当研究はホットな分野といえます。今回は「欺瞞」に焦点をあてていますが、成果によってはとても汎用性が高い研究なので、今後は一般的な世論の分析などにも活用できると思います。

また、これは長期的で包括的な目標ですが、現状よりも格段に人間に近い知能を開発したいと考えています。ChatGPTなどの大規模言語モデルの裏側にはTransformerと呼ばれる仕組みがあるのですが、簡単に言えば、「次の単語をひたすら予想していく」ものです。その予想をする際に、人間であれば記憶から予想に繋げますが、Transformerには本質的に記憶がないので、人間の思考に近づけるためにはこの点を見直さなければいけないと思っています。長期的な目標になりますが、これが実現すればコンピュータが人間に近い知能を持つようになり、ブレイクスルーを起こせるのではないかと期待しています。

先ほども述べた通り、目まぐるしく進化し、状況が変わっていくAI分野の研究は、計画通りに進まないこともあります。そのなかで、規模の大きなセコム財団の特定領域研究助成に採択していただき、本当に助かりました。資金面はもちろんですが、状況に合わせて自由に研究を進めさせていただけていることも、大変ありがたく感じています。

そして何よりも、選考員の先生方がとても強力な布陣で、省庁へのご紹介をいただいたり、研究の中身が一部変わるほどのご助言を頂戴することができました。心から感謝しております。

社会全体として、扇動的な「悪」への対処が可能にならなければいけない。その危機感を持って研究に取り組んでいる

社会全体として、扇動的な「悪」への対処が可能にならなければいけない。その危機感を持って研究に取り組んでいる