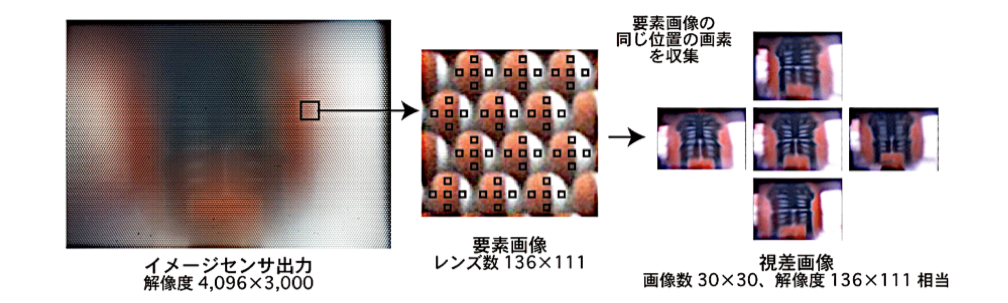

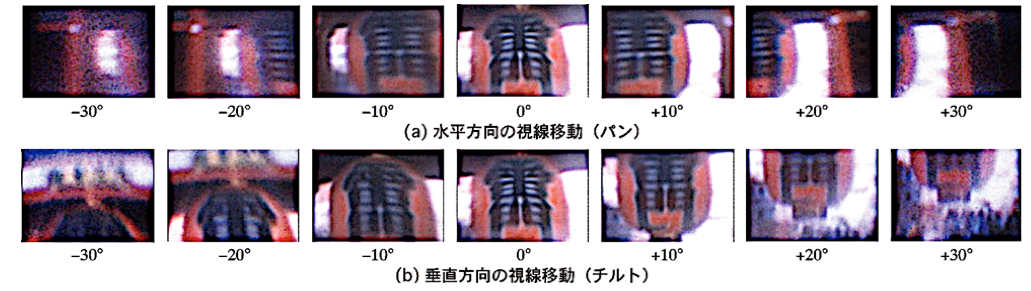

はい。次に、4Kイメージセンサの撮影画像をご覧ください。画像は東京・浅草寺の雷門を撮影したものです。提灯の右端部分を撮影したレンズアレイには、それぞれ似たような、提灯の右端部分の要素画像がたくさん映っています。単なる撮影画像(イメージセンサ出力)だけでは、ぼやけて曖昧なものですが、この中の同じ位置の要素画像に対して、専用の視差画像合成プログラムを組み、収集することで、より鮮明でくっきりとした視差画像を生成できるようになるのです。この実験結果では、パンチルト角±30°にまで対応していることがお分かりいただけるかと思います。

イメージセンサの撮影画像から生成した視差画像

イメージセンサの撮影画像から生成した視差画像 パンチルトの実験結果

パンチルトの実験結果

ひとりで行う仕事を、できるだけ多人数で処理することで効率化を図る。これが分散マルチGPUシステムの発想

ひとりで行う仕事を、できるだけ多人数で処理することで効率化を図る。これが分散マルチGPUシステムの発想